- GRAVITATION - Gravitation et astrophysique

- GRAVITATION - Gravitation et astrophysiqueSi l’on excepte la théorie classique de l’électromagnétisme, introduite bien plus tard par James Clerk Maxwell (1865), aucune théorie physique d’expression aussi simple que la loi du carré inverse de la distance, de Newton (1687), n’a jamais été aussi féconde. Si on laisse de côté quelques phénomènes «exotiques» découverts depuis la fin des années soixante, presque tous les phénomènes astrophysiques connus peuvent être décrits correctement par la théorie newtonienne. Les théoriciens de la gravitation espèrent que les progrès des techniques d’observation et d’expérimentation à la fois astronomiques et terrestres modifieront cette situation (par exemple par l’observation de trous noirs ou la détection d’ondes gravitationnelles), mais, pour l’instant, il est toujours vrai que les quelques phénomènes observés avec certitude et dont l’explication exige l’utilisation d’une théorie plus sophistiquée, comme celle d’Einstein (cf. GRAVITATION - Histoire des idées et RELATIVITÉ), sont intrinsèquement d’importance mineure. En dehors de la première section d’introduction, le présent article se limitera donc aux phénomènes qui peuvent être décrits simplement en termes newtoniens.1. GénéralitésLe terme «gravitation» est employé depuis l’époque de Newton pour désigner le mécanisme de l’attraction résiduelle mutuelle agissant à distance entre les objets, indépendamment de la nature spécifique de la matière dont ils sont constitués. Cette propriété – indépendance de la nature de la matière – fut établie par Galilée en 1638, avec la formulation de ce qui est maintenant connu sous le nom de principe d’équivalence. Celui-ci traduit le fait que, si les effets mettant en jeu la nature physico-chimique des corps (comme la résistance de l’air, les forces magnétiques...) sont éliminés, n’importe quel petit corps tombera vers la Terre avec la même accélération む (par rapport à un repère de référence lié à la Terre). Newton interpréta ce champ gravitationnel apparent む mesuré localement comme la somme d’une petite contribution centrifuge (compensant l’accélération due à la rotation de la Terre) et d’une contribution strictement gravitationnelle ゔ, où le vecteur champ ゔ doit être envisagé comme s’étendant à tout l’espace et représentant l’accélération totale (par rapport à un repère inertiel) de tout corps libre de l’influence de forces non gravitationnelles. Newton compléta sa théorie en postulant que ゔ se compose de la somme des contributions de chaque élément microscopique de matière, proportionnellement à leur masse, en suivant la célèbre loi de l’inverse du carré de la distance. Si r représente la distance à l’élément et 轢 face="EU Caron" チ le vecteur unitaire orienté dans sa direction, le champ gravitationnel est donné par:

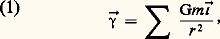

où représente une sommation sur tous les éléments de masse m non nulle, et où G est la constante d’attraction universelle. Dans le cas d’un objet sphérique, l’évaluation de la sommation peut être obtenue immédiatement: le champ à l’extérieur de l’objet est le même que si un seul élément microscopique de masse M = m était placé en son centre.La théorie newtonienne, exprimée par l’équation (1), est non seulement capable de rendre compte des lois de Kepler, déjà connues (1621), qui gouvernent le mouvement périodique des planètes autour du Soleil, ou des satellites autour des planètes, mais elle permet aussi de prévoir correctement les dérives de ce mouvement périodique dues aux interactions entre planètes [cf. MÉCANIQUE CÉLESTE]. Réciproquement, et de manière tout à fait indépendante, la première grande réussite de la théorie fut son utilisation, par Urbain Jean Joseph Le Verrier et John Couch Adams, pour prédire l’existence de la planète Neptune, jamais observée jusqu’alors, afin d’expliquer les anomalies des orbites des autres planètes. La faculté de la théorie de Newton de permettre des prévisions qualitatives et quantitatives précises dans des contextes d’une grande généralité surclassait tout ce qui était connu jusque-là. En outre, à part quelques anomalies qui ne sont pratiquement pas mesurables (la plus importante concerne la précession du périhélie de l’orbite de Mercure), la théorie de Newton permet de rendre compte de tous les phénomènes gravitationnels observés antérieurement à la découverte des quasars et du rayonnement du corps noir cosmologique, vers les années 1960-1970.Bien que la théorie newtonienne demeure parfaitement adaptée à toutes les applications pratiques (trajectographie des satellites artificiels ou des sondes spatiales, mais aussi applications astrophysiques), la nécessité d’introduire une théorie de la gravitation plus sophistiquée devint évidente dès 1905, quand Einstein publia son mémoire sur la relativité restreinte, de façon à rendre compte des propriétés des phénomènes électromagnétiques en général, et de la lumière en particulier. L’abolition par Einstein du concept de positions mesurables de manière absolue dans l’espace (déterminées par exemple relativement à l’éther, en fonction duquel était exprimée la théorie du champ électromagnétique de James Clerk Maxwell) n’était rien d’autre qu’un retour au concept incarné par le principe de la relativité galiléenne , lequel était tout à fait compatible avec la théorie de Newton, et avait en outre été très bien accepté au cours des XVIIe et XIXe siècles. Cependant, la théorie de la relativité restreinte abolissait également l’idée de simultanéité absolue, qui était essentielle au concept de temps traditionnel, fondement de la mécanique newtonienne. Cette révolution était nécessaire pour expliquer le phénomène, autrement incompréhensible, de la constance de la vitesse de la lumière – environ 3 憐 108 m 練s-1 pour des observateurs se déplaçant arbitrairement l’un par rapport à l’autre. Einstein perçut immédiatement la nécessité d’introduire une nouvelle théorie compatible avec celle de Newton dans le cas limite des vitesses très inférieures à celle de la lumière, mais en accord avec la théorie de la relativité restreinte lorsque les effets gravitationnels sont négligeables. Il reconnut également que la nouvelle théorie devrait être compatible avec le principe d’équivalence , c’est-à-dire l’équivalence des masses inertielle et gravitationnelle. Ce principe était déjà inclu dans la théorie newtonienne, et a été vérifié avec une précision étonnante: 1 pour 109 par l’expérience d’Eötvös en 1890; les travaux plus récents de Robert H. Dicke et Brazinsky ont confirmé ce résultat avec une précision de 1 pour 1012.Einstein conclut que, pour être compatible avec ce principe, la nouvelle théorie relativiste devrait inclure les effets gravitationnels dans la structure de base de l’espace-temps. La façon la plus simple d’y parvenir fut mise en évidence pour la première fois par Einstein lui-même dans sa théorie de la relativité générale en 1915. Bien que de nombreuses autres solutions aient été proposées depuis lors, elles sont toutes beaucoup plus compliquées, ou se sont révélées contraires à l’évidence observationnelle. La précession du périhélie de l’orbite de la planète Mercure a longtemps constitué la vérification la plus précise de la théorie d’Einstein, mais une confirmation encore meilleure a été fournie par l’étude des orbites des pulsars doubles, dont il est possible de mesurer la perte d’énergie par rayonnement gravitationnel de la manière prévue par Einstein. (Les tentatives ébauchées par Joseph Weber vers 1970 pour détecter directement le rayonnement gravitationnel à partir de dispositifs expérimentaux terrestres n’ont pas encore été couronnés de succès.) En dépit de cette confirmation de la relativité générale dans le cas limite des champs très faibles, l’observation astronomique n’a pas encore pu fournir d’exemple de ses prévisions les plus remarquables, concernant les effets de forte courbure dans les champs gravitationnels très intenses. L’exemple le plus caractéristique d’un tel effet est la formation des trous noirs, qui proviennent de l’effondrement, dû au mécanisme d’instabilité qui sera décrit au chapitre Gravitation et évolution stellaire de corps célestes extrêmement denses. Pourtant, et bien que plusieurs phénomènes astronomiques aient été observés (depuis le sol ou grâce au télescope spatial Hubble, en particulier)dont les trous noirs pourraient être responsables, il n’y a toujours pas de preuve directe que les propriétés de ces derniers soient telles que les annonce la théorie, ni même qu’ils existent réellement. Le but du présent article étant de décrire les applications de la théorie de la gravitation aux phénomènes astrophysiques certains, nous sommes en droit de rester dans le cadre conceptuel relativement simple de la théorie newtonienne.Avant d’abandonner le thème des théories gravitationnelles plus sophistiquées, nous devons signaler que, même si les progrès futurs de l’astronomie apportent une confirmation expérimentale décisive de la relativité générale, celle-ci nécessitera encore des aménagements pour des raisons purement théoriques. De même que la théorie de Newton a dû être généralisée de manière à être compatible avec les principes de la relativité restreinte, la théorie d’Einstein devra être généralisée de manière à être compatible avec les principes de la théorie quantique, établis essentiellement entre 1925 et 1930 par Max Born, Erwin Schrödinger, Werner Karl Heisenberg, Paul Dirac... La version classique de la relativité générale place la gravité sur un plan différent de celui des champs rencontrés habituellement en physique, en l’incorporant dans la structure fondamentale de l’espace-temps. Pourtant, la plupart des auteurs de tentatives récentes pour introduire la gravitation dans le cadre de l’actuelle théorie quantique des champs ont essayé de rétablir la gravité comme champ ordinaire, au même titre que les autres, mais s’en distinguant par les quantas correspondants, à savoir les gravitons, qui devraient avoir deux unités fondamentales de spin. Bien qu’aucune théorie quantique de la gravitation entièrement satisfaisante n’ait été bâtie à ce jour, des espoirs considérables ont été soulevés par une technique d’approche fondée sur les principes appliqués avec succès à la théorie des faibles interactions par Sheldon Glashow, Steven Weinberg, Abdus Salam, Gerhard’t Hooft... vers 1970. Il a été suggéré (par Bruno Zumino, Stanley Deser, Peter van Nieuwenhuizen... vers 1975) que les mêmes principes pourraient peut-être être adaptés à la gravitation en appliquant une certaine condition, appelée «supersymétrie», ce qui serait réalisable en incluant des particules hypothétiques de spin 3/2, les «gravitinos», en plus des gravitons ordinaires, de spin égal à 2, de la théorie.2. Mesure de la constante de gravitation universelle et structure de la TerreÀ part son application à la mécanique céleste, la première répercussion importante de la théorie newtonienne de la gravitation a été l’explication de la structure de la Terre. Un résultat mathématique d’importance historique a été le calcul, par le mathématicien écossais Colin Maclaurin, vers 1740, de la configuration d’équilibre exacte d’un corps rigide en rotation, sous l’influence de son propre champ gravitationnel, avec les hypothèses simplificatrices suivantes: tout d’abord, la densité est partout uniforme; ensuite, ce corps se déforme comme un fluide (ce qui serait le cas s’il était suffisamment lourd pour que sa masse l’emporte sur toutes les contraintes internes). Presque toutes les expériences significatives concernant la gravitation effectuées au XVIIIe siècle avaient pour but de vérifier que la solution du sphéroïde aplati aux pôles de Maclaurin était applicable à la Terre et, par conséquent, de démontrer la validité des hypothèses sur lesquelles elle était fondée.Dans ce domaine, le plus grand pionnier a été l’astronome français Pierre Bouguer. Une expédition française sous le commandement de Bouguer et La Condamine fut envoyée au Pérou en 1737 afin de déterminer la valeur de l’aplatissement de la Terre (qui présentait un intérêt pratique pour la navigation, aussi bien qu’un intérêt théorique). Bien que l’expédition ait atteint son objectif officiel (en mesurant la différence des distances correspondant à un degré de latitude respectivement à l’équateur et en Europe), elle est surtout célèbre par les tentatives courageuses mais infructueuses de Bouguer pour déterminer la densité moyenne D de la Terre, l’application du modèle de Maclaurin étant justifiée s’il était possible de montrer que D n’était pas trop grande en comparaison de la densité connue des rochers de la croûte terrestre (voisine de 3). La mesure de base nécessaire à la détermination de D est évidemment très simple: connaissant le rayon R de la Terre, il suffit d’obtenir sa masse M en mesurant l’intensité 塚 du champ gravitationnel ゔ à la surface. Puisque l’aplatissement, attendu et observé, de la Terre est très faible (moins de 1 p. 100), une estimation très précise peut être obtenue à l’aide de l’approximation sphérique, qui donne:

où représente une sommation sur tous les éléments de masse m non nulle, et où G est la constante d’attraction universelle. Dans le cas d’un objet sphérique, l’évaluation de la sommation peut être obtenue immédiatement: le champ à l’extérieur de l’objet est le même que si un seul élément microscopique de masse M = m était placé en son centre.La théorie newtonienne, exprimée par l’équation (1), est non seulement capable de rendre compte des lois de Kepler, déjà connues (1621), qui gouvernent le mouvement périodique des planètes autour du Soleil, ou des satellites autour des planètes, mais elle permet aussi de prévoir correctement les dérives de ce mouvement périodique dues aux interactions entre planètes [cf. MÉCANIQUE CÉLESTE]. Réciproquement, et de manière tout à fait indépendante, la première grande réussite de la théorie fut son utilisation, par Urbain Jean Joseph Le Verrier et John Couch Adams, pour prédire l’existence de la planète Neptune, jamais observée jusqu’alors, afin d’expliquer les anomalies des orbites des autres planètes. La faculté de la théorie de Newton de permettre des prévisions qualitatives et quantitatives précises dans des contextes d’une grande généralité surclassait tout ce qui était connu jusque-là. En outre, à part quelques anomalies qui ne sont pratiquement pas mesurables (la plus importante concerne la précession du périhélie de l’orbite de Mercure), la théorie de Newton permet de rendre compte de tous les phénomènes gravitationnels observés antérieurement à la découverte des quasars et du rayonnement du corps noir cosmologique, vers les années 1960-1970.Bien que la théorie newtonienne demeure parfaitement adaptée à toutes les applications pratiques (trajectographie des satellites artificiels ou des sondes spatiales, mais aussi applications astrophysiques), la nécessité d’introduire une théorie de la gravitation plus sophistiquée devint évidente dès 1905, quand Einstein publia son mémoire sur la relativité restreinte, de façon à rendre compte des propriétés des phénomènes électromagnétiques en général, et de la lumière en particulier. L’abolition par Einstein du concept de positions mesurables de manière absolue dans l’espace (déterminées par exemple relativement à l’éther, en fonction duquel était exprimée la théorie du champ électromagnétique de James Clerk Maxwell) n’était rien d’autre qu’un retour au concept incarné par le principe de la relativité galiléenne , lequel était tout à fait compatible avec la théorie de Newton, et avait en outre été très bien accepté au cours des XVIIe et XIXe siècles. Cependant, la théorie de la relativité restreinte abolissait également l’idée de simultanéité absolue, qui était essentielle au concept de temps traditionnel, fondement de la mécanique newtonienne. Cette révolution était nécessaire pour expliquer le phénomène, autrement incompréhensible, de la constance de la vitesse de la lumière – environ 3 憐 108 m 練s-1 pour des observateurs se déplaçant arbitrairement l’un par rapport à l’autre. Einstein perçut immédiatement la nécessité d’introduire une nouvelle théorie compatible avec celle de Newton dans le cas limite des vitesses très inférieures à celle de la lumière, mais en accord avec la théorie de la relativité restreinte lorsque les effets gravitationnels sont négligeables. Il reconnut également que la nouvelle théorie devrait être compatible avec le principe d’équivalence , c’est-à-dire l’équivalence des masses inertielle et gravitationnelle. Ce principe était déjà inclu dans la théorie newtonienne, et a été vérifié avec une précision étonnante: 1 pour 109 par l’expérience d’Eötvös en 1890; les travaux plus récents de Robert H. Dicke et Brazinsky ont confirmé ce résultat avec une précision de 1 pour 1012.Einstein conclut que, pour être compatible avec ce principe, la nouvelle théorie relativiste devrait inclure les effets gravitationnels dans la structure de base de l’espace-temps. La façon la plus simple d’y parvenir fut mise en évidence pour la première fois par Einstein lui-même dans sa théorie de la relativité générale en 1915. Bien que de nombreuses autres solutions aient été proposées depuis lors, elles sont toutes beaucoup plus compliquées, ou se sont révélées contraires à l’évidence observationnelle. La précession du périhélie de l’orbite de la planète Mercure a longtemps constitué la vérification la plus précise de la théorie d’Einstein, mais une confirmation encore meilleure a été fournie par l’étude des orbites des pulsars doubles, dont il est possible de mesurer la perte d’énergie par rayonnement gravitationnel de la manière prévue par Einstein. (Les tentatives ébauchées par Joseph Weber vers 1970 pour détecter directement le rayonnement gravitationnel à partir de dispositifs expérimentaux terrestres n’ont pas encore été couronnés de succès.) En dépit de cette confirmation de la relativité générale dans le cas limite des champs très faibles, l’observation astronomique n’a pas encore pu fournir d’exemple de ses prévisions les plus remarquables, concernant les effets de forte courbure dans les champs gravitationnels très intenses. L’exemple le plus caractéristique d’un tel effet est la formation des trous noirs, qui proviennent de l’effondrement, dû au mécanisme d’instabilité qui sera décrit au chapitre Gravitation et évolution stellaire de corps célestes extrêmement denses. Pourtant, et bien que plusieurs phénomènes astronomiques aient été observés (depuis le sol ou grâce au télescope spatial Hubble, en particulier)dont les trous noirs pourraient être responsables, il n’y a toujours pas de preuve directe que les propriétés de ces derniers soient telles que les annonce la théorie, ni même qu’ils existent réellement. Le but du présent article étant de décrire les applications de la théorie de la gravitation aux phénomènes astrophysiques certains, nous sommes en droit de rester dans le cadre conceptuel relativement simple de la théorie newtonienne.Avant d’abandonner le thème des théories gravitationnelles plus sophistiquées, nous devons signaler que, même si les progrès futurs de l’astronomie apportent une confirmation expérimentale décisive de la relativité générale, celle-ci nécessitera encore des aménagements pour des raisons purement théoriques. De même que la théorie de Newton a dû être généralisée de manière à être compatible avec les principes de la relativité restreinte, la théorie d’Einstein devra être généralisée de manière à être compatible avec les principes de la théorie quantique, établis essentiellement entre 1925 et 1930 par Max Born, Erwin Schrödinger, Werner Karl Heisenberg, Paul Dirac... La version classique de la relativité générale place la gravité sur un plan différent de celui des champs rencontrés habituellement en physique, en l’incorporant dans la structure fondamentale de l’espace-temps. Pourtant, la plupart des auteurs de tentatives récentes pour introduire la gravitation dans le cadre de l’actuelle théorie quantique des champs ont essayé de rétablir la gravité comme champ ordinaire, au même titre que les autres, mais s’en distinguant par les quantas correspondants, à savoir les gravitons, qui devraient avoir deux unités fondamentales de spin. Bien qu’aucune théorie quantique de la gravitation entièrement satisfaisante n’ait été bâtie à ce jour, des espoirs considérables ont été soulevés par une technique d’approche fondée sur les principes appliqués avec succès à la théorie des faibles interactions par Sheldon Glashow, Steven Weinberg, Abdus Salam, Gerhard’t Hooft... vers 1970. Il a été suggéré (par Bruno Zumino, Stanley Deser, Peter van Nieuwenhuizen... vers 1975) que les mêmes principes pourraient peut-être être adaptés à la gravitation en appliquant une certaine condition, appelée «supersymétrie», ce qui serait réalisable en incluant des particules hypothétiques de spin 3/2, les «gravitinos», en plus des gravitons ordinaires, de spin égal à 2, de la théorie.2. Mesure de la constante de gravitation universelle et structure de la TerreÀ part son application à la mécanique céleste, la première répercussion importante de la théorie newtonienne de la gravitation a été l’explication de la structure de la Terre. Un résultat mathématique d’importance historique a été le calcul, par le mathématicien écossais Colin Maclaurin, vers 1740, de la configuration d’équilibre exacte d’un corps rigide en rotation, sous l’influence de son propre champ gravitationnel, avec les hypothèses simplificatrices suivantes: tout d’abord, la densité est partout uniforme; ensuite, ce corps se déforme comme un fluide (ce qui serait le cas s’il était suffisamment lourd pour que sa masse l’emporte sur toutes les contraintes internes). Presque toutes les expériences significatives concernant la gravitation effectuées au XVIIIe siècle avaient pour but de vérifier que la solution du sphéroïde aplati aux pôles de Maclaurin était applicable à la Terre et, par conséquent, de démontrer la validité des hypothèses sur lesquelles elle était fondée.Dans ce domaine, le plus grand pionnier a été l’astronome français Pierre Bouguer. Une expédition française sous le commandement de Bouguer et La Condamine fut envoyée au Pérou en 1737 afin de déterminer la valeur de l’aplatissement de la Terre (qui présentait un intérêt pratique pour la navigation, aussi bien qu’un intérêt théorique). Bien que l’expédition ait atteint son objectif officiel (en mesurant la différence des distances correspondant à un degré de latitude respectivement à l’équateur et en Europe), elle est surtout célèbre par les tentatives courageuses mais infructueuses de Bouguer pour déterminer la densité moyenne D de la Terre, l’application du modèle de Maclaurin étant justifiée s’il était possible de montrer que D n’était pas trop grande en comparaison de la densité connue des rochers de la croûte terrestre (voisine de 3). La mesure de base nécessaire à la détermination de D est évidemment très simple: connaissant le rayon R de la Terre, il suffit d’obtenir sa masse M en mesurant l’intensité 塚 du champ gravitationnel ゔ à la surface. Puisque l’aplatissement, attendu et observé, de la Terre est très faible (moins de 1 p. 100), une estimation très précise peut être obtenue à l’aide de l’approximation sphérique, qui donne: En tenant compte d’une petite correction centrifuge connue, la valeur de 塚 est donnée par l’intensité g du champ gravitationnel apparent む, qui avait été mesuré par Bouguer d’après la méthode de Galilée. Elle consiste à étalonner un pendule simple dont la période 精 est donnée en fonction de la longueur l par: 精 = 2 神 (l/g )1/2. Par cette méthode, il est très facile d’obtenir la valeur du produit GM. Cependant, afin de parfaire l’évaluation de la masse M, et par conséquent de la densité moyenne D = 3 M/4 神R2, il faut connaître la constante de gravitation universelle G, qui n’avait jamais été mesurée. Bouguer entreprit alors la première tentative sérieuse d’estimation de G, en mesurant les perturbations du champ gravitationnel apparent む dues à la présence de la cordillère des Andes.La première des deux méthodes décrites dans l’ouvrage de Bouguer La Figure de la Terre (Paris, 1749) était fondée sur la comparaison de la valeur de g au niveau de la mer, avec sa valeur g mesurée à une altitude h , sur un haut plateau de la cordillère, en utilisant la formule:

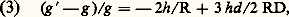

En tenant compte d’une petite correction centrifuge connue, la valeur de 塚 est donnée par l’intensité g du champ gravitationnel apparent む, qui avait été mesuré par Bouguer d’après la méthode de Galilée. Elle consiste à étalonner un pendule simple dont la période 精 est donnée en fonction de la longueur l par: 精 = 2 神 (l/g )1/2. Par cette méthode, il est très facile d’obtenir la valeur du produit GM. Cependant, afin de parfaire l’évaluation de la masse M, et par conséquent de la densité moyenne D = 3 M/4 神R2, il faut connaître la constante de gravitation universelle G, qui n’avait jamais été mesurée. Bouguer entreprit alors la première tentative sérieuse d’estimation de G, en mesurant les perturbations du champ gravitationnel apparent む dues à la présence de la cordillère des Andes.La première des deux méthodes décrites dans l’ouvrage de Bouguer La Figure de la Terre (Paris, 1749) était fondée sur la comparaison de la valeur de g au niveau de la mer, avec sa valeur g mesurée à une altitude h , sur un haut plateau de la cordillère, en utilisant la formule: qui serait valable pour un plateau de densité moyenne d , pourvu que sa base soit grande par rapport à sa largeur, mais petite par rapport au rayon terrestre, et pourvu que la structure de la croûte terrestre supportant le plateau ne soit pas affectée par sa présence. Cette dernière hypothèse constitue en fait le point faible de la méthode, puisque, comme Hervé Faye et George Biddell Airy l’ont montré ultérieurement, l’existence d’un haut plateau tend à provoquer une dépression de la croûte sous-jacente: en effet, si le plateau est supposé flotter librement sur une «mer» de rochers plus denses, le dernier terme, proportionnel au rapport des densités d /D, disparaît complètement. En pratique, la croûte terrestre est suffisamment rigide pour qu’un effet résiduel demeure; néanmoins, la première estimation de D effectuée par Bouguer était beaucoup trop élevée. Bien que cette méthode se soit ainsi révélée inadéquate pour la détermination de G, des mesures de ce type sont utilisées couramment par les géologues avec l’objectif inverse, à savoir l’estimation des densités de structures rocheuses cachées à partir d’une valeur de G connue [cf. GRAVIMÉTRIE].La seconde méthode de Bouguer pour l’évaluation de D et G est en principe mieux adaptée à son but. Cette méthode consiste à évaluer les variations de g dues à la présence d’une montagne proche, non en intensité, mais en direction, ce qui peut être fait en mesurant la déviation d’un fil à plomb par rapport à la verticale, repérée d’après l’observation astronomique d’étoiles convenablement choisies. Cette méthode est en principe plus sûre que la première, parce que l’effet observé dépend essentiellement de la densité de la portion de montagne située au-dessus de la base, et qu’ainsi les conséquences de l’incertitude quant à la structure géologique du sous-sol sont moins graves.En pratique, Bouguer n’a pas réussi à exploiter sa méthode, en partie parce que le volcan où il a effectué ses mesures, le Chimborazo, était mal adapté à cet objectif, mais surtout en raison de la difficulté de mesurer une déviation inférieure à une minute d’arc dans des conditions pénibles sur le terrain, à l’aide des instruments primitifs disponibles à l’époque. Cette seconde méthode a été exploitée avec succès trente ans plus tard par l’astronome royal britannique Nevil Maskelyne, en collaboration avec le géologue James Hutton, au mont Shiehallion en Écosse, montagne plus petite, mais géologiquement moins complexe que le Chimborazo. Leurs travaux ont été si minutieux que leur résultat, D = 5 pour la densité moyenne de la Terre (correspondant à la valeur G = 7 練10-11 m-3 練kg-1 練s-2 pour la constante de gravitation universelle), s’écarte de moins de 10 p. 100 de la valeur connue aujourd’hui.Le progrès suivant est fondé sur une méthode entièrement nouvelle introduite par le clergyman anglais John Michell, ancien professeur de géologie à Cambridge. Pour éliminer les inconnues géologiques qui avaient complètement faussé la première méthode de Bouguer et, à un degré moindre, la seconde, Michell imagina pour la mesure de G une expérience de laboratoire, où les conditions étaient entièrement contrôlables. Son idée était d’utiliser des poids lourds mais compacts (constitués de matière très dense, comme le plomb ou, idéalement, l’or) suspendus aux extrémités d’un balancier, luimême suspendu en son milieu à un long fil métallique. Ce fil devait être choisi aussi fin que possible, afin d’offrir une résistance à la torsion extrêmement faible. Il serait ainsi possible de détecter la déviation horizontale du balancier résultant de forces gravitationnelles, même très faibles, exercées sur l’un des deux poids par une troisième masse lourde et compacte placée à proximité.La mort de Michell en 1793 l’empêcha de parachever son expérience, mais son dispositif expérimental fut repris et amélioré par Henry Cavendish qui, en 1798, obtint un résultat avec une précision de deux chiffres significatifs, à savoir G = 6,7 練 10-11 m3 練kg-1 練s-2, ce qui correspond à une densité moyenne pour la Terre D = 5,5. La méthode du pendule de torsion de Michell constitue le point de départ des progrès de la précision vers les trois chiffres significatifs, obtenus au XIXe siècle, le résultat étant G = 6,67 練 10-11 m3 練kg-1 練s-2. Ce degré de précision n’a guère été amélioré à ce jour, même par les travaux les plus récents (G = 6,672 59 練 10-11 m3 練kg-1 練s-2). Outre la mesure de G, qui était son objectif initial, la méthode de Michell a été adaptée par le physicien hongrois Loránt Eötvös, aux environs de 1890, dans le but tout différent de tester le principe d’équivalence (cf. supra , Généralités ). La technique d’Eötvös a permis de vérifier le principe d’équivalence avec une précision de un pour 1011, imposant ainsi des restrictions rigoureuses à d’éventuelles généralisations de la théorie de Newton.3. Équilibre gravitationnel et relaxation de l’énergie dans les étoilesAprès la percée décisive que constituait la mesure de G, l’interprétation physique des phénomènes gravitationnels progressa peu durant près d’un siècle, si l’on excepte quelques spéculations audacieuses qui préfiguraient la théorie moderne des trous noirs: John Michell lui-même, dès 1784, puis Pierre Simon de Laplace, en 1796, montrèrent qu’un corps suffisamment massif et compact pourrait avoir un champ gravitationnel assez intense pour empêcher même la lumière d’échapper à son attraction. Pour qu’un projectile puisse s’échapper dans l’espace à partir de la surface d’un corps sphérique de rayon R et de masse M, sa vélocité initiale v devrait être telle que son énergie cinétique par unité de masse, v2/2, dépasse l’énergie gravitationnelle correspondante, GM/R. Si l’on admet la représentation de la lumière en termes de corpuscules émis avec la vitesse c et soumis à la mécanique newtonienne, on en déduit qu’elle ne pourra pas être émise à partir d’un tel corps de masse M et de rayon R à moins que R n’excède une valeur critique (appelée «rayon de Schwarzschild») égale à 2 GM/c 2 (pour un corps ayant la densité du Soleil, le rayon critique est du même ordre de grandeur que le diamètre de l’orbite de la Terre). Toutefois, il était prématuré à cette époque de spéculer sur l’existence de tels corps célestes invisibles, car cela soulevait des questions insolubles avant le développement, au cours du XXe siècle, des théories relativistes de la gravitation. À cette époque, les théories mathématiques progressaient considérablement grâce à différents chercheurs, notamment d’Alembert et Laplace, qui rendirent possible la reformulation de la loi newtonienne de la pesanteur dans le langage de la mécanique du continu. Dans ce formalisme, la loi originelle (1) de l’inverse du carré de la distance se trouve remplacée par l’équation de Poisson (1813), qui relie le potentiel du champ gravitationnel U à la densité de matière de la source 福 par la relation:

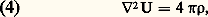

qui serait valable pour un plateau de densité moyenne d , pourvu que sa base soit grande par rapport à sa largeur, mais petite par rapport au rayon terrestre, et pourvu que la structure de la croûte terrestre supportant le plateau ne soit pas affectée par sa présence. Cette dernière hypothèse constitue en fait le point faible de la méthode, puisque, comme Hervé Faye et George Biddell Airy l’ont montré ultérieurement, l’existence d’un haut plateau tend à provoquer une dépression de la croûte sous-jacente: en effet, si le plateau est supposé flotter librement sur une «mer» de rochers plus denses, le dernier terme, proportionnel au rapport des densités d /D, disparaît complètement. En pratique, la croûte terrestre est suffisamment rigide pour qu’un effet résiduel demeure; néanmoins, la première estimation de D effectuée par Bouguer était beaucoup trop élevée. Bien que cette méthode se soit ainsi révélée inadéquate pour la détermination de G, des mesures de ce type sont utilisées couramment par les géologues avec l’objectif inverse, à savoir l’estimation des densités de structures rocheuses cachées à partir d’une valeur de G connue [cf. GRAVIMÉTRIE].La seconde méthode de Bouguer pour l’évaluation de D et G est en principe mieux adaptée à son but. Cette méthode consiste à évaluer les variations de g dues à la présence d’une montagne proche, non en intensité, mais en direction, ce qui peut être fait en mesurant la déviation d’un fil à plomb par rapport à la verticale, repérée d’après l’observation astronomique d’étoiles convenablement choisies. Cette méthode est en principe plus sûre que la première, parce que l’effet observé dépend essentiellement de la densité de la portion de montagne située au-dessus de la base, et qu’ainsi les conséquences de l’incertitude quant à la structure géologique du sous-sol sont moins graves.En pratique, Bouguer n’a pas réussi à exploiter sa méthode, en partie parce que le volcan où il a effectué ses mesures, le Chimborazo, était mal adapté à cet objectif, mais surtout en raison de la difficulté de mesurer une déviation inférieure à une minute d’arc dans des conditions pénibles sur le terrain, à l’aide des instruments primitifs disponibles à l’époque. Cette seconde méthode a été exploitée avec succès trente ans plus tard par l’astronome royal britannique Nevil Maskelyne, en collaboration avec le géologue James Hutton, au mont Shiehallion en Écosse, montagne plus petite, mais géologiquement moins complexe que le Chimborazo. Leurs travaux ont été si minutieux que leur résultat, D = 5 pour la densité moyenne de la Terre (correspondant à la valeur G = 7 練10-11 m-3 練kg-1 練s-2 pour la constante de gravitation universelle), s’écarte de moins de 10 p. 100 de la valeur connue aujourd’hui.Le progrès suivant est fondé sur une méthode entièrement nouvelle introduite par le clergyman anglais John Michell, ancien professeur de géologie à Cambridge. Pour éliminer les inconnues géologiques qui avaient complètement faussé la première méthode de Bouguer et, à un degré moindre, la seconde, Michell imagina pour la mesure de G une expérience de laboratoire, où les conditions étaient entièrement contrôlables. Son idée était d’utiliser des poids lourds mais compacts (constitués de matière très dense, comme le plomb ou, idéalement, l’or) suspendus aux extrémités d’un balancier, luimême suspendu en son milieu à un long fil métallique. Ce fil devait être choisi aussi fin que possible, afin d’offrir une résistance à la torsion extrêmement faible. Il serait ainsi possible de détecter la déviation horizontale du balancier résultant de forces gravitationnelles, même très faibles, exercées sur l’un des deux poids par une troisième masse lourde et compacte placée à proximité.La mort de Michell en 1793 l’empêcha de parachever son expérience, mais son dispositif expérimental fut repris et amélioré par Henry Cavendish qui, en 1798, obtint un résultat avec une précision de deux chiffres significatifs, à savoir G = 6,7 練 10-11 m3 練kg-1 練s-2, ce qui correspond à une densité moyenne pour la Terre D = 5,5. La méthode du pendule de torsion de Michell constitue le point de départ des progrès de la précision vers les trois chiffres significatifs, obtenus au XIXe siècle, le résultat étant G = 6,67 練 10-11 m3 練kg-1 練s-2. Ce degré de précision n’a guère été amélioré à ce jour, même par les travaux les plus récents (G = 6,672 59 練 10-11 m3 練kg-1 練s-2). Outre la mesure de G, qui était son objectif initial, la méthode de Michell a été adaptée par le physicien hongrois Loránt Eötvös, aux environs de 1890, dans le but tout différent de tester le principe d’équivalence (cf. supra , Généralités ). La technique d’Eötvös a permis de vérifier le principe d’équivalence avec une précision de un pour 1011, imposant ainsi des restrictions rigoureuses à d’éventuelles généralisations de la théorie de Newton.3. Équilibre gravitationnel et relaxation de l’énergie dans les étoilesAprès la percée décisive que constituait la mesure de G, l’interprétation physique des phénomènes gravitationnels progressa peu durant près d’un siècle, si l’on excepte quelques spéculations audacieuses qui préfiguraient la théorie moderne des trous noirs: John Michell lui-même, dès 1784, puis Pierre Simon de Laplace, en 1796, montrèrent qu’un corps suffisamment massif et compact pourrait avoir un champ gravitationnel assez intense pour empêcher même la lumière d’échapper à son attraction. Pour qu’un projectile puisse s’échapper dans l’espace à partir de la surface d’un corps sphérique de rayon R et de masse M, sa vélocité initiale v devrait être telle que son énergie cinétique par unité de masse, v2/2, dépasse l’énergie gravitationnelle correspondante, GM/R. Si l’on admet la représentation de la lumière en termes de corpuscules émis avec la vitesse c et soumis à la mécanique newtonienne, on en déduit qu’elle ne pourra pas être émise à partir d’un tel corps de masse M et de rayon R à moins que R n’excède une valeur critique (appelée «rayon de Schwarzschild») égale à 2 GM/c 2 (pour un corps ayant la densité du Soleil, le rayon critique est du même ordre de grandeur que le diamètre de l’orbite de la Terre). Toutefois, il était prématuré à cette époque de spéculer sur l’existence de tels corps célestes invisibles, car cela soulevait des questions insolubles avant le développement, au cours du XXe siècle, des théories relativistes de la gravitation. À cette époque, les théories mathématiques progressaient considérablement grâce à différents chercheurs, notamment d’Alembert et Laplace, qui rendirent possible la reformulation de la loi newtonienne de la pesanteur dans le langage de la mécanique du continu. Dans ce formalisme, la loi originelle (1) de l’inverse du carré de la distance se trouve remplacée par l’équation de Poisson (1813), qui relie le potentiel du champ gravitationnel U à la densité de matière de la source 福 par la relation: où 暴2 représente l’opérateur de Laplace, c’est-à-dire la divergence du gradient. Mais, contrairement aux mathématiques pures, les progrès en physique furent différés jusqu’au développement de la thermodynamique et de la théorie cinétique des gaz, au milieu du XIXe siècle. Il devint alors possible, pour la première fois, d’essayer de comprendre la structure du Soleil, considéré comme un corps gazeux dans lequel la distribution de matière est déterminée par l’équilibre entre les forces autogravitationnelles et la pression du gaz. Une fois que le lien entre la pression du gaz, l’énergie thermique macroscopique et l’énergie cinétique des particules constituantes eut été trouvé, un nouveau domaine s’ouvrit à l’investigation mathématique. Un résultat particulièrement important et utile fut le théorème du viriel reliant le potentiel d’attraction mutuelle 行 (intrinsèquement négatif) à l’énergie cinétique interne T du gaz d’un corps sous l’effet de sa propre gravitation. Après avoir été développé sous différentes formes par plusieurs chercheurs du XIXe siècle, le théorème du viriel fut exprimé de manière particulièrement succincte par Henri Poincaré en 1912:

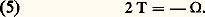

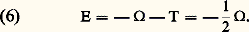

où 暴2 représente l’opérateur de Laplace, c’est-à-dire la divergence du gradient. Mais, contrairement aux mathématiques pures, les progrès en physique furent différés jusqu’au développement de la thermodynamique et de la théorie cinétique des gaz, au milieu du XIXe siècle. Il devint alors possible, pour la première fois, d’essayer de comprendre la structure du Soleil, considéré comme un corps gazeux dans lequel la distribution de matière est déterminée par l’équilibre entre les forces autogravitationnelles et la pression du gaz. Une fois que le lien entre la pression du gaz, l’énergie thermique macroscopique et l’énergie cinétique des particules constituantes eut été trouvé, un nouveau domaine s’ouvrit à l’investigation mathématique. Un résultat particulièrement important et utile fut le théorème du viriel reliant le potentiel d’attraction mutuelle 行 (intrinsèquement négatif) à l’énergie cinétique interne T du gaz d’un corps sous l’effet de sa propre gravitation. Après avoir été développé sous différentes formes par plusieurs chercheurs du XIXe siècle, le théorème du viriel fut exprimé de manière particulièrement succincte par Henri Poincaré en 1912: Cette relation reste valable si le corps n’est pas exactement à l’équilibre statique (à condition de faire la moyenne des oscillations) pourvu que seules des forces (gravitationnelles et éventuellement électrostatiques) suivant une loi en 1/r 2 entrent en jeu entre les particules constituantes. Dans ces conditions, le théorème peut s’appliquer avec une excellente précision au Soleil et aux autres étoiles «ordinaires» (étoiles de la séquence principale), mais évidemment pas à la Terre ni aux planètes, qui nécessitent une version généralisée tenant compte de la plus grande complexité des forces mises en jeu dans les liquides et les solides. Dans le cas particulier du Soleil, l’observation extérieure de sa masse M et de son rayon R suffit pour estimer approximativement la limite inférieure de son énergie potentielle autogravitationnelle 行, à partir de laquelle on peut déduire que l’énergie interne T du gaz correspond à une température centrale de l’ordre de quelques dizaines de millions de degrés (cela contraste avec la température observée à la surface, quelques milliers de degrés seulement). William Thomson (qui devint plus tard lord Kelvin) fut le premier à entreprendre sérieusement des recherches dans cette direction, en 1863. Reprenant une suggestion antérieure mais non publiée de Hermann von Helmholtz, Thomson évalua l’énergie totale E qui aurait dû être libérée pendant la formation du Soleil à partir d’un nuage gazeux primitif, présumé diffus:

Cette relation reste valable si le corps n’est pas exactement à l’équilibre statique (à condition de faire la moyenne des oscillations) pourvu que seules des forces (gravitationnelles et éventuellement électrostatiques) suivant une loi en 1/r 2 entrent en jeu entre les particules constituantes. Dans ces conditions, le théorème peut s’appliquer avec une excellente précision au Soleil et aux autres étoiles «ordinaires» (étoiles de la séquence principale), mais évidemment pas à la Terre ni aux planètes, qui nécessitent une version généralisée tenant compte de la plus grande complexité des forces mises en jeu dans les liquides et les solides. Dans le cas particulier du Soleil, l’observation extérieure de sa masse M et de son rayon R suffit pour estimer approximativement la limite inférieure de son énergie potentielle autogravitationnelle 行, à partir de laquelle on peut déduire que l’énergie interne T du gaz correspond à une température centrale de l’ordre de quelques dizaines de millions de degrés (cela contraste avec la température observée à la surface, quelques milliers de degrés seulement). William Thomson (qui devint plus tard lord Kelvin) fut le premier à entreprendre sérieusement des recherches dans cette direction, en 1863. Reprenant une suggestion antérieure mais non publiée de Hermann von Helmholtz, Thomson évalua l’énergie totale E qui aurait dû être libérée pendant la formation du Soleil à partir d’un nuage gazeux primitif, présumé diffus: En admettant que cette énergie de contraction gravitationnelle était libérée par rayonnement de façon à peu près constante jusqu’à nos jours, Thomson parvint à la conclusion inattendue que le Soleil ne pouvait pas être beaucoup plus âgé que cinquante millions d’années, ce qui était en contradiction flagrante avec l’évidence géologique que la vie sur Terre existe dans des conditions qui ne sont pas radicalement différentes de celles d’aujourd’hui depuis plusieurs centaines de millions d’années au moins (en fait, depuis plusieurs milliards d’années selon les résultats les plus récents).La façon la plus simple de résoudre ce paradoxe est de supposer que, contrairement à l’hypothèse de Helmholtz et Kelvin, l’énergie rayonnant de la surface du Soleil doit être alimentée par quelque autre source d’énergie interne en sus de l’énergie de contraction gravitationnelle donnée par l’équation (6). Conformément à nos connaissances actuelles, qui remontent aux travaux de George Anthony Gamow et Hans Albrecht Bethe vers 1930, la principale source d’énergie, non seulement dans le Soleil, mais dans toutes les étoiles de la séquence principale, est fournie par la conversion de l’hydrogène en hélium par combustion thermonucléaire; cette réaction s’effectue à la cadence requise pour avoir une température centrale située dans la gamme déduite de l’équation (5), c’est-à-dire quelques dizaines de millions de degrés. Bien qu’elle ne constitue pas la source principale d’énergie pour le Soleil ni les autres étoiles «ordinaires», le mécanisme de la contraction gravitationnelle de Helmholtz et Kelvin apparaît toutefois comme étant d’importance primordiale dans d’autres cas. Tandis que l’énergie nucléaire ne peut jamais dépasser une très petite fraction (environ 1 p. 100) de l’énergie théoriquement disponible (donnée par la célèbre formule d’Einstein E = mc 2) à partir de la masse restante du matériau constituant l’étoile, aucune limite de ce genre n’est imposée à l’énergie gravitationnelle. Celle-ci est donnée pour une étoile de masse M par la formule:

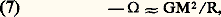

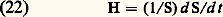

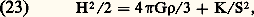

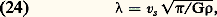

En admettant que cette énergie de contraction gravitationnelle était libérée par rayonnement de façon à peu près constante jusqu’à nos jours, Thomson parvint à la conclusion inattendue que le Soleil ne pouvait pas être beaucoup plus âgé que cinquante millions d’années, ce qui était en contradiction flagrante avec l’évidence géologique que la vie sur Terre existe dans des conditions qui ne sont pas radicalement différentes de celles d’aujourd’hui depuis plusieurs centaines de millions d’années au moins (en fait, depuis plusieurs milliards d’années selon les résultats les plus récents).La façon la plus simple de résoudre ce paradoxe est de supposer que, contrairement à l’hypothèse de Helmholtz et Kelvin, l’énergie rayonnant de la surface du Soleil doit être alimentée par quelque autre source d’énergie interne en sus de l’énergie de contraction gravitationnelle donnée par l’équation (6). Conformément à nos connaissances actuelles, qui remontent aux travaux de George Anthony Gamow et Hans Albrecht Bethe vers 1930, la principale source d’énergie, non seulement dans le Soleil, mais dans toutes les étoiles de la séquence principale, est fournie par la conversion de l’hydrogène en hélium par combustion thermonucléaire; cette réaction s’effectue à la cadence requise pour avoir une température centrale située dans la gamme déduite de l’équation (5), c’est-à-dire quelques dizaines de millions de degrés. Bien qu’elle ne constitue pas la source principale d’énergie pour le Soleil ni les autres étoiles «ordinaires», le mécanisme de la contraction gravitationnelle de Helmholtz et Kelvin apparaît toutefois comme étant d’importance primordiale dans d’autres cas. Tandis que l’énergie nucléaire ne peut jamais dépasser une très petite fraction (environ 1 p. 100) de l’énergie théoriquement disponible (donnée par la célèbre formule d’Einstein E = mc 2) à partir de la masse restante du matériau constituant l’étoile, aucune limite de ce genre n’est imposée à l’énergie gravitationnelle. Celle-ci est donnée pour une étoile de masse M par la formule: où R est un rayon «moyen» convenablement défini, nécessairement inférieur au rayon englobant la totalité de la matière. Dans le cas de la classe d’étoiles appelées naines blanches, pour lesquelles R est seulement de l’ordre de 10 000 km (comparé avec le rayon solaire, de l’ordre de 1 000 000 km), l’énergie gravitationnelle 漣 行 n’est en aucune façon négligeable par rapport à l’énergie nucléaire maximale disponible. Dans le cas des étoiles à neutrons, encore plus denses (dont l’existence a été révélée grâce aux pulsars, découvert en 1968) et pour lesquelles le rayon moyen est seulement de l’ordre d’une dizaine de kilomètres, l’énergie gravitationnelle 漣 行 est en fait comparable à l’énergie de la masse restante elle-même. De telles classes d’étoiles qui, en dépit de leur faible rayon, ont toujours des masses comparables à celle du Soleil, sont supposées être l’aboutissement de l’évolution des étoiles après épuisement des sources ordinaires d’énergie nucléaire [cf. ÉTOILES]. Des configurations encore plus «exotiques», dans lesquelles l’énergie gravitationnelle est presque entièrement dominante, se rencontrent dans les quasars et les noyaux actifs de galaxies, qui semblent renfermer des dizaines de millions de fois la masse d’une étoile ordinaire à l’intérieur de dimensions comparables à celles de notre système solaire. Ces objets rares et lointains sont l’objet de nombreuses études et il semble probable que des mécanismes de relaxation de l’énergie gravitationnelle extrêmement efficaces (dans lesquels les trous noirs sont peut-être impliqués) en soient à l’origine.4. Gravitation et évolution stellaireBien que les étoiles de la classe la plus répandue dans notre Galaxie et ailleurs aient des rayons extrêmement variables, leurs masses diffèrent en général assez peu de celle du Soleil (environ d’un facteur dix). Cela correspond au fait que, quels que soient leur rayon et leur densité, toutes les variétés «normales» d’étoiles comportent le même nombre N de baryons (nombre total de protons et de neutrons contenu dans tout le noyau atomique) dont l’ordre de grandeur approché est:

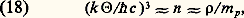

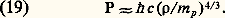

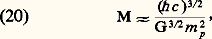

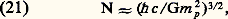

où R est un rayon «moyen» convenablement défini, nécessairement inférieur au rayon englobant la totalité de la matière. Dans le cas de la classe d’étoiles appelées naines blanches, pour lesquelles R est seulement de l’ordre de 10 000 km (comparé avec le rayon solaire, de l’ordre de 1 000 000 km), l’énergie gravitationnelle 漣 行 n’est en aucune façon négligeable par rapport à l’énergie nucléaire maximale disponible. Dans le cas des étoiles à neutrons, encore plus denses (dont l’existence a été révélée grâce aux pulsars, découvert en 1968) et pour lesquelles le rayon moyen est seulement de l’ordre d’une dizaine de kilomètres, l’énergie gravitationnelle 漣 行 est en fait comparable à l’énergie de la masse restante elle-même. De telles classes d’étoiles qui, en dépit de leur faible rayon, ont toujours des masses comparables à celle du Soleil, sont supposées être l’aboutissement de l’évolution des étoiles après épuisement des sources ordinaires d’énergie nucléaire [cf. ÉTOILES]. Des configurations encore plus «exotiques», dans lesquelles l’énergie gravitationnelle est presque entièrement dominante, se rencontrent dans les quasars et les noyaux actifs de galaxies, qui semblent renfermer des dizaines de millions de fois la masse d’une étoile ordinaire à l’intérieur de dimensions comparables à celles de notre système solaire. Ces objets rares et lointains sont l’objet de nombreuses études et il semble probable que des mécanismes de relaxation de l’énergie gravitationnelle extrêmement efficaces (dans lesquels les trous noirs sont peut-être impliqués) en soient à l’origine.4. Gravitation et évolution stellaireBien que les étoiles de la classe la plus répandue dans notre Galaxie et ailleurs aient des rayons extrêmement variables, leurs masses diffèrent en général assez peu de celle du Soleil (environ d’un facteur dix). Cela correspond au fait que, quels que soient leur rayon et leur densité, toutes les variétés «normales» d’étoiles comportent le même nombre N de baryons (nombre total de protons et de neutrons contenu dans tout le noyau atomique) dont l’ordre de grandeur approché est: Un des plus grands progrès dans l’interprétation des phénomènes gravitationnels a été de comprendre, essentiellement grâce à l’œuvre de Arthur Stanley Eddington, que l’existence de cette masse stellaire caractéristique pouvait être interprétée à l’aide de considérations de stabilité, et que la valeur considérable donnée par la relation (8) résultait de la valeur très faible du couplage gravitationnel mesuré en unités de physique microscopique. À titre de comparaison, la force de répulsion électrostatique entre deux électrons, ou la force d’attraction entre un proton et un électron, peut être caractérisée par la constante de couplage sans dimension, appelée constante de structure fine:

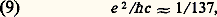

Un des plus grands progrès dans l’interprétation des phénomènes gravitationnels a été de comprendre, essentiellement grâce à l’œuvre de Arthur Stanley Eddington, que l’existence de cette masse stellaire caractéristique pouvait être interprétée à l’aide de considérations de stabilité, et que la valeur considérable donnée par la relation (8) résultait de la valeur très faible du couplage gravitationnel mesuré en unités de physique microscopique. À titre de comparaison, la force de répulsion électrostatique entre deux électrons, ou la force d’attraction entre un proton et un électron, peut être caractérisée par la constante de couplage sans dimension, appelée constante de structure fine: où e est la charge de l’électron ou du proton, et 寮 la constante de Planck. Contrairement à cette valeur très raisonnable, la constante de couplage analogue caractérisant l’attraction gravitationnelle entre deux protons de masse m p est:

où e est la charge de l’électron ou du proton, et 寮 la constante de Planck. Contrairement à cette valeur très raisonnable, la constante de couplage analogue caractérisant l’attraction gravitationnelle entre deux protons de masse m p est: Le rapport considérable entre ces deux nombres est le même que celui qui existe entre la force électrostatique et la force gravitationnelle, quelle que soit la distance. Cependant, les forces gravitationnelles peuvent l’emporter pour des phénomènes à grande échelle, en dépit de leur très faible valeur relative, parce qu’elles sont toujours attractives et, par conséquent, se renforcent mutuellement, contrairement aux forces électrostatiques, qui tendent à s’annuler entre charges de signes opposés quand de grands nombres de particules sont concernés.Afin de comprendre la relation entre le très grand nombre (8) et le très petit nombre (10), revenons au théorème du viriel, qui peut être interprété comme l’expression de l’équilibre entre le «support» de la pression interne et l’attraction autogravitationnelle du corps considéré. Dans une forme moins générale mais plus précise que la relation (5) (face=F0019 漣 行 = 2T), cet équilibre peut s’écrire sous la forme:

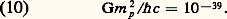

Le rapport considérable entre ces deux nombres est le même que celui qui existe entre la force électrostatique et la force gravitationnelle, quelle que soit la distance. Cependant, les forces gravitationnelles peuvent l’emporter pour des phénomènes à grande échelle, en dépit de leur très faible valeur relative, parce qu’elles sont toujours attractives et, par conséquent, se renforcent mutuellement, contrairement aux forces électrostatiques, qui tendent à s’annuler entre charges de signes opposés quand de grands nombres de particules sont concernés.Afin de comprendre la relation entre le très grand nombre (8) et le très petit nombre (10), revenons au théorème du viriel, qui peut être interprété comme l’expression de l’équilibre entre le «support» de la pression interne et l’attraction autogravitationnelle du corps considéré. Dans une forme moins générale mais plus précise que la relation (5) (face=F0019 漣 行 = 2T), cet équilibre peut s’écrire sous la forme: où 磊 et 福 sont respectivement les valeurs moyennes de la pression interne P et de la densité 福 de l’étoile, et où est un paramètre sans dimension de l’ordre de l’unité (dont la valeur précise dépend de la constitution détaillée de l’étoile et de la façon dont les valeurs moyennes sont définies). La relation (11) a une conséquence évidente importante; tant que les variations de pression et de densité peuvent être traitées comme étant reliées par une loi en puissance simple de la forme classique:

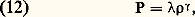

où 磊 et 福 sont respectivement les valeurs moyennes de la pression interne P et de la densité 福 de l’étoile, et où est un paramètre sans dimension de l’ordre de l’unité (dont la valeur précise dépend de la constitution détaillée de l’étoile et de la façon dont les valeurs moyennes sont définies). La relation (11) a une conséquence évidente importante; tant que les variations de pression et de densité peuvent être traitées comme étant reliées par une loi en puissance simple de la forme classique: où le facteur de proportionnalité et l’exposant 塚 sont des constantes, un équilibre stable ne peut être obtenu que pour:

où le facteur de proportionnalité et l’exposant 塚 sont des constantes, un équilibre stable ne peut être obtenu que pour: Pourvu que cette inégalité soit vérifiée, une pression interne excessive par rapport à celle qui est exigée par l’équation (11) sera compensée par une expansion de l’étoile, tandis qu’une pression insuffisante sera augmentée par contraction. Cependant, si l’inégalité (13) n’est pas respectée, tout équilibre momentané sera instable: la plus légère surpression provoquera une explosion, tandis que la moindre baisse de pression donnera lieu à un effondrement.Dans le cas le plus simple, où le gaz se compose de particules ordinaires non relativistes, avec des interactions à courte échelle négligeables (condition nécessaire à la validité de l’équation (5)), la théorie classique des gaz montre que, pour des variations de courte durée (pour lesquelles les effets thermiques non adiabatiques sont négligeables) l’exposant 塚 est donné par:

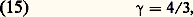

Pourvu que cette inégalité soit vérifiée, une pression interne excessive par rapport à celle qui est exigée par l’équation (11) sera compensée par une expansion de l’étoile, tandis qu’une pression insuffisante sera augmentée par contraction. Cependant, si l’inégalité (13) n’est pas respectée, tout équilibre momentané sera instable: la plus légère surpression provoquera une explosion, tandis que la moindre baisse de pression donnera lieu à un effondrement.Dans le cas le plus simple, où le gaz se compose de particules ordinaires non relativistes, avec des interactions à courte échelle négligeables (condition nécessaire à la validité de l’équation (5)), la théorie classique des gaz montre que, pour des variations de courte durée (pour lesquelles les effets thermiques non adiabatiques sont négligeables) l’exposant 塚 est donné par: ce qui se situe largement à l’intérieur du domaine de stabilité requis par la relation (13). Toutefois, dans le cas d’un gaz constitué de particules animées de vitesses comparables à celle de la lumière, où les effets relativistes sont importants, la valeur correspondante de 塚 sera réduite et tendra précisément vers la valeur critique:

ce qui se situe largement à l’intérieur du domaine de stabilité requis par la relation (13). Toutefois, dans le cas d’un gaz constitué de particules animées de vitesses comparables à celle de la lumière, où les effets relativistes sont importants, la valeur correspondante de 塚 sera réduite et tendra précisément vers la valeur critique: qui est l’extrême limite relativiste, atteinte par exemple dans le cas d’un gaz purement radiatif, constitué uniquement de photons. L’importance pratique de ce fait provient de ce que, dans un gaz suffisamment chaud, le rayonnement thermique du corps noir fournit une contribution non négligeable à la pression effective. La formule classique de Stefan-Boltzmann pour la contribution Pr issue de ce rayonnement thermique est:

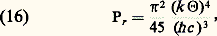

qui est l’extrême limite relativiste, atteinte par exemple dans le cas d’un gaz purement radiatif, constitué uniquement de photons. L’importance pratique de ce fait provient de ce que, dans un gaz suffisamment chaud, le rayonnement thermique du corps noir fournit une contribution non négligeable à la pression effective. La formule classique de Stefan-Boltzmann pour la contribution Pr issue de ce rayonnement thermique est: où k est la constante de Boltzmann et 粒 la température absolue. Cette contribution Pr est à comparer à celle des particules gazeuses ordinaires non relativistes (les électrons et les noyaux atomiques de l’étoile), Pg , qui, dans la plupart des cas (en supposant l’absence de conditions extrêmes telle la dégénérescence due aux très hautes pressions), est donnée simplement par:

où k est la constante de Boltzmann et 粒 la température absolue. Cette contribution Pr est à comparer à celle des particules gazeuses ordinaires non relativistes (les électrons et les noyaux atomiques de l’étoile), Pg , qui, dans la plupart des cas (en supposant l’absence de conditions extrêmes telle la dégénérescence due aux très hautes pressions), est donnée simplement par: où n est le nombre de particules non relativistes par unité de volume. La valeur de la densité numérique n peut être estimée en divisant la densité massique 福 par la masse moyenne d’une particule, de l’ordre de grandeur de la masse du proton, m p . La condition pour que les deux contributions, radiative et gazeuse, Pr et Pg , soient approximativement du même ordre de grandeur peut alors s’exprimer par:

où n est le nombre de particules non relativistes par unité de volume. La valeur de la densité numérique n peut être estimée en divisant la densité massique 福 par la masse moyenne d’une particule, de l’ordre de grandeur de la masse du proton, m p . La condition pour que les deux contributions, radiative et gazeuse, Pr et Pg , soient approximativement du même ordre de grandeur peut alors s’exprimer par: et, quand cette condition est satisfaite, l’ordre de grandeur de la pression totale est:

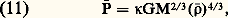

et, quand cette condition est satisfaite, l’ordre de grandeur de la pression totale est: Par conséquent, d’après la relation (11), cette propriété – coexistence de contributions de nature radiative et gazeuse d’importance équivalente – se produit dans les étoiles dont la masse M est de l’ordre de:

Par conséquent, d’après la relation (11), cette propriété – coexistence de contributions de nature radiative et gazeuse d’importance équivalente – se produit dans les étoiles dont la masse M est de l’ordre de: valeur qui est à peine supérieure à la masse du Soleil. Ainsi, comme Eddington l’avait fait remarquer vers 1925, nous pouvons conclure que, pour les étoiles de masse inférieure ou égale à celle du Soleil, la pression du gaz, non relativiste, prédominera: pour de telles étoiles, la valeur de 塚 est proche de 5/3, et la condition de stabilité (13) est remplie. Cependant, pour les étoiles beaucoup plus massives, c’est la pression de rayonnement qui prévaut; la valeur de 塚 est proche de 4/3; par conséquent une telle étoile est à la limite de l’instabilité et risque de ne pas exister très longtemps dans des conditions naturelles. Presque toutes les cosmologies s’accordent sur le fait que les étoiles se sont formées à partir de la condensation de nuages gazeux initialement diffus. Le raisonnement précédent montre pourquoi on peut s’attendre à ce qu’une protoétoile, formée à partir d’un tel nuage, soit assez instable pour se fractionner en sous-unités de plus en plus petites, jusqu’à ce que sa masse atteigne l’ordre de grandeur défini par la relation (20); à ce stade, les sous-unités vont se stabiliser sous la forme d’étoiles ordinaires. Le nombre de baryons d’une telle étoile s’obtient en divisant la masse donnée par la relation (20) par la masse m p du proton (la masse du neutron est à peu près identique, et les autres corrections de masse telles que celles qui sont dues aux électrons sont relativement négligeables). On arrive ainsi à la conclusion que le nombre de baryons caractéristique des étoiles stables ordinaire est:

valeur qui est à peine supérieure à la masse du Soleil. Ainsi, comme Eddington l’avait fait remarquer vers 1925, nous pouvons conclure que, pour les étoiles de masse inférieure ou égale à celle du Soleil, la pression du gaz, non relativiste, prédominera: pour de telles étoiles, la valeur de 塚 est proche de 5/3, et la condition de stabilité (13) est remplie. Cependant, pour les étoiles beaucoup plus massives, c’est la pression de rayonnement qui prévaut; la valeur de 塚 est proche de 4/3; par conséquent une telle étoile est à la limite de l’instabilité et risque de ne pas exister très longtemps dans des conditions naturelles. Presque toutes les cosmologies s’accordent sur le fait que les étoiles se sont formées à partir de la condensation de nuages gazeux initialement diffus. Le raisonnement précédent montre pourquoi on peut s’attendre à ce qu’une protoétoile, formée à partir d’un tel nuage, soit assez instable pour se fractionner en sous-unités de plus en plus petites, jusqu’à ce que sa masse atteigne l’ordre de grandeur défini par la relation (20); à ce stade, les sous-unités vont se stabiliser sous la forme d’étoiles ordinaires. Le nombre de baryons d’une telle étoile s’obtient en divisant la masse donnée par la relation (20) par la masse m p du proton (la masse du neutron est à peu près identique, et les autres corrections de masse telles que celles qui sont dues aux électrons sont relativement négligeables). On arrive ainsi à la conclusion que le nombre de baryons caractéristique des étoiles stables ordinaire est: ce qui est en bon accord avec la valeur observée de 1058 (8).Peu après qu’Eddington eut démontré la difficulté d’avoir des configurations d’équilibre gravitationnel stables pour des masses très supérieures à la valeur caractéristique donnée en (20) (déduction confirmée ultérieurement par les travaux plus détaillés de M. Schwarzschild et d’autres), Subrahmanyan Chandrasekhar obtint en 1931 un résultat encore plus remarquable en montrant qu’à la fin de sa vie active (après épuisement de toutes les réserves d’énergie thermonucléaire ou autre) une étoile ne peut atteindre un état d’équilibre froid, comme celui d’une planète, que si la masse restante est inférieure à une valeur critique dont l’ordre de grandeur est donnée par la relation (20), et qui correspond plus précisément à une fois et demie environ la masse du Soleil [cf. ÉTOILES]. Le calcul intial de Chandrasekhar, qui utilisait la théorie quantique des gaz dégénérés à haute densité, très récente à l’époque, était fondé sur l’hypothèse que le gaz stellaire était composé de noyaux atomiques et d’électrons ordinaires. Cependant, d’autres chercheurs (Lev Davidovitch Landau, Robert Julius Oppenheimer...) s’aperçurent bientôt que cette conclusion (bien qu’avec une valeur de la masse critique exacte légèrement supérieure) restait valable même pour les configurations de très forte densité, appelées étoiles à neutrons, dans lesquelles les noyaux ont fusionné et absorbé les électrons de manière à former une nouvelle sorte de fluide, composé principalement de neutrons. Il en résulte que, à moins que leur matière ne soit dispersée par un vent stellaire ou par une ultime explosion, des étoiles à peine quelques fois plus massives que le Soleil finissent leur vie en s’effondrant sur elles-mêmes et en créant un trou noir.5. Théorie newtonienne de la gravitation et cosmologieIl est remarquable qu’en dépit des nombreux efforts pour obtenir une preuve expérimentale en faveur de modèles théoriques beaucoup plus compliqués, on puisse toujours donner une représentation satisfaisante de ce que nous savons des propriétés de l’Univers à l’aide d’un modèle cosmologique de la plus grande simplicité concevable, à savoir celui d’une explosion isotrope et homogène. Autrement dit, l’Univers peut être représenté par un modèle obéissant au principe cosmologique selon lequel toutes les positions et toutes les directions sont équivalentes dans l’espace, mais dans lequel la densité diminue avec le temps, au fur et à mesure que les particules de matière s’éloignent les unes des autres. Il est tout aussi remarquable que l’existence de tels modèles ait été dédaignée non seulement par Newton et ses disciples, mais même par Einstein, en dépit de leur simplicité et de leur compatibilité avec la théorie newtonienne de la gravitation, aussi bien qu’avec celle de la relativité générale. La raison semble en être la suivante: une fois entérinée par Galilée, la révolution copernicienne, en rejetant la notion d’Univers centré sur notre propre planète, avait ouvert la voie à l’idée d’un Univers homogène dans lequel toutes les positions sont équivalentes sur une échelle suffisamment grande; or un prolongement naturel de cette découverte conduit à penser que l’Univers devrait également être stationnaire dans le temps, c’est-à-dire que, en accord avec ce que Hermann Bondi et Thomas Gold ont appelé le principe cosmologique parfait (1948), toutes les époques devraient être équivalentes, au même titre que les positions et les directions. La tentation récurrente d’adopter un modèle stationnaire, en dépit de la quantité croissante de preuves défavorables fournies par l’observation, n’est pas due simplement à l’attraction esthétique de la symétrie mathématique. Il semblerait que, pour beaucoup de théoriciens, une raison plus profonde réside dans la fascination exercée par l’idée que le monde (matériel et, par voie de conséquence, biologique) devrait être éternel. L’attachement à cette idée est responsable d’un surprenant record d’aveuglement, apparemment volontaire, dont un exemple a été fourni par Paul Dirac (1961, dans un débat avec Robert H. Dicke) lorsqu’il refusa de tenir compte du principe anthropique dans son argumentation en faveur de théories de la pesanteur dans lesquelles le couplage s’affaiblit avec le temps. L’aspiration à une «éternité temporelle» est également responsable de recherches plus solidement motivées, comme la théorie de l’état stationnaire de H. Bondi, T. Gold et Fred Hoyle (1950, 1951), quelque temps à la mode, bien que pas davantage plausible, et la tentative originale de Freeman J. Dyson (1979) pour redéfinir le temps biologique en termes de théorie de l’information.Alors qu’il est compréhensible que des physiciens de haut niveau aient accordé peu d’attention au naïf concept biblique d’une création soudaine de l’Univers à un moment bien défini du passé, il est plus surprenant qu’ils ne se soient pas préoccupés plus tôt du fait pourtant évident que, la nuit, le ciel entre les étoiles est sombre . S’appuyant sur les remarques de Jean Philippe Loys de Chéseaux (1744), Heinrich Olbers a été à peu près le seul à s’apercevoir (en 1822) que cette observation était incompatible avec le principe cosmologique parfait (à moins d’enfreindre les lois ordinaires de la conservation, comme dans la théorie de l’état stationnaire). Le paradoxe d’Olbers-de Chéseaux est fondé sur la remarque suivante: bien que l’angle solide occupé dans le ciel par une étoile solitaire diminue avec la distance, dans un Univers homogène cet effet est annulé par l’augmentation du nombre d’étoiles avec les dimensions du domaine considéré; on peut donc en déduire que les étoiles doivent obligatoirement avoir été créées à une époque déterminée dans le passé (de sorte que la lumière des plus éloignées ne puisse pas encore nous avoir atteint), car autrement la lumière provenant d’étoiles à des distances toujours plus grandes rendrait le ciel entier aussi brillant qu’une étoile moyenne! Par contre, les théoriciens, y compris Einstein, ont effectivement réalisé que, dans n’importe quelle théorie de la gravitation purement attractive, et en particulier dans la version initiale (1916) de la relativité générale, comme dans la théorie newtonienne, un Univers homogène ne pourrait en aucune façon rester stationnaire, à cause de la tendance de la matière à s’effondrer sur elle-même. Einstein reconnut par la suite s’être engagé à la légère, lorsqu’il proposa (en 1917) de modifier sa théorie (par addition d’un terme 炙) de manière à y inclure un effet de répulsion cosmique, nécessaire à l’existence d’un Univers stationnaire. Ce faisant, Einstein ne remarqua même pas que cette modification de circonstance ne résolvait nullement le paradoxe d’Olbers-de Chéseaux. C’est ainsi qu’il revint au mathématicien russe Alexandre Friedmann de fonder la théorie de la cosmologie moderne en 1922, en introduisant une classe de modèles dits du Big Bang originel (explosion à partir d’un état initial de densité infiniment élevée). De telles théories sont tout à fait compatibles avec les théories classiques de la gravitation, purement attractives, dans lesquelles l’expansion initiale sera d’abord ralentie, et, plus tard, peut-être (mais pas nécessairement) inversée. En outre, ces modèles ne soulèvent pas de difficulté avec le paradoxe d’Olbers-de Chéseaux, puisque l’existence d’un âge fini pour l’Univers implique une limite maximale finie à partir de laquelle la lumière peut atteindre un observateur à un moment donné (l’intensité de la lumière issue de sources éloignées diminue progressivement à cause de l’effet Doppler – décalage vers le rouge – dû à la vitesse relative d’éloignement de la source).Bien que les théories du Big Bang aient été initialement formulées dans le cadre de la relativité générale (dans sa version classique, purement attractive), Edward Arthur Milne et William Hunter McCrea s’aperçurent ensuite (en 1934) que les propriétés locales des modèles de Friedmann peuvent être traduites en termes purement newtoniens pourvu que la loi de la pesanteur soit formulée localement à l’aide de l’équation de Poisson (4) et non de la version originelle (1), qui, comme Newton lui-même l’avait remarqué, donne une somme divergente si elle est appliquée à une distribution de matière non bornée. Les modèles de Big Bang newtoniens de Milne et McCrea peuvent être caractérisés par une distribution de matière non bornée, de densité uniforme, subissant une expansion de symétrie sphérique (purement radiale) par rapport à un point central fixé. Lorsque l’on a affaire à une distribution de matière finie, l’ambiguïté de la solution de l’équation (2) du champ gravitationnel est normalement résolue en supposant que le champ tend vers zéro à grande distance, ce qui conduit automatiquement à un résultat équivalent à celui qui est obtenu par l’application de la formule (1) en 1/r 2. Dans les modèles de Milne et McCrea, l’ambiguïté de la solution de (2) est résolue simplement par l’exigence d’une symétrie sphérique autour du point central choisi.Bien que la façon dont ces modèles cosmologiques newtoniens ont été présentés fasse référence à une position centrale particulière, ils sont néanmoins strictement homogènes dans le sens que toutes les propriétés physiques mesurables sont partout les mêmes. Cette propriété essentielle (qui peut au premier abord paraître surprenante si l’on considère que les vitesses de récession et l’accélération gravitationnelle augmentent proportionnellement à la distance au centre) vient de ce que la théorie de Newton, comme celle d’Einstein, satisfait le principe d’équivalence , qui signifie que ni le champ gravitationnel local ゔ, ni l’accélération ne sont physiquement définissables en eux-mêmes, seule la différence む = ゔ 漣 étant directement mesurable. Dans le cas présent, ce champ gravitationnel apparent む est en fait nul partout. Ainsi n’y a-t-il pas de changement mesurable si, au lieu d’utiliser un système de référence ayant pour origine le point central initialement choisi, nous changeons pour un système centré sur une autre particule matérielle et possédant une accélération relative non nulle par rapport au premier système.Les modèles relativistes initiaux de Friedmann aussi bien que les modèles newtoniens de Milne et McCrea sont régis par la même équation dynamique, selon laquelle la vitesse: